Appleが米国特許商標庁(USPTO)に出願した、モーションセンサーによるキーワード検出に関する特許が公開されました。今日は今後のSiriの改善に繋がりそうな、このニュースを紹介したいと思います。

Scribd.com / Apple Patent Keyword Detection Using Motion Sensing

Apple Insider / Siri could learn to lip read using motion detection

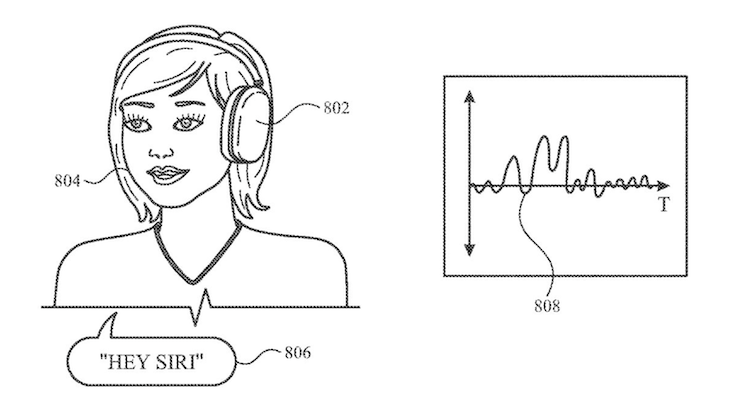

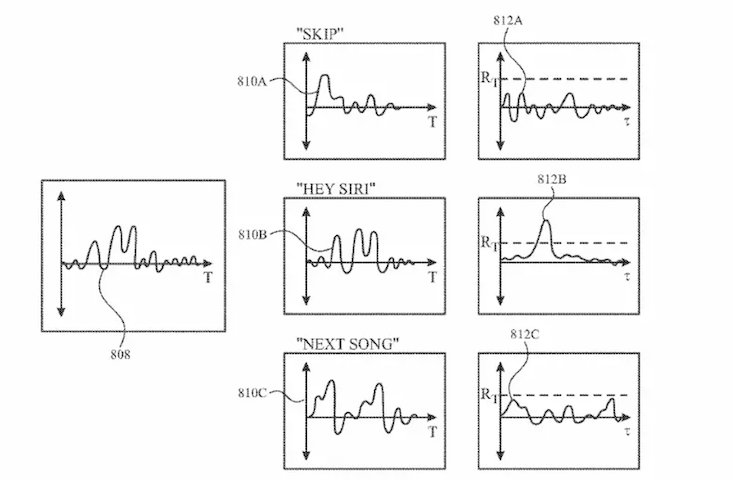

特許の内容は、ユーザーが発話をする際にユーザーの口・顔・頭・首は振動しますが、これをAppleのデバイスに内蔵された加速度計やジャイロスコープなどのモーションセンサーを使うことで唇の動きとして検出できるというもの。Siriにこの機能を実装することで、音声認識に関して様々な利点があるというわけです。

しかし、モーションセンサーだけで音声認識するという考え方ではなく、あくまでマイクからの音声入力と組み合わせる仕組みとなっています。音声入力とモーションセンサーのデータを照合して精度を上げたり、マイクが拾った雑音や意図しない音を排除するために活用することが想定されています。また、マイクなどのオーディオセンサーに比べて少ない電力で動くモーションセンサーを活用することで、ユーザーが音声の発話を積極的に行っていない時にマイクをオフにして消費電力を減らすことも可能になるとしています。たしかに、デバイスがウェイクワード「Hey Siri」「Siri」などを聞くためにマイクがオンになっている状態は電力的にもCPUパワー的にも無駄ですよね。

モーションセンサーは顔についている必要があるため、AirPods、Apple Vision Proなどが現時点で想定されるデバイスとなります。

以前紹介した、HomePodにカメラを搭載してアイトラッキングする特許とはアプローチは全く違っていますが、音声デバイスの性能向上を目指す工夫は常に考えられているのだなと感心します。

ちなみに、映像の唇の動きから発話の内容を読み取る技術として「読唇術」「読話」「口話」と呼ばれる手法があります。人間の読唇術においては、熟練した読み取り手が、補聴器などから得られる情報を参考にしつつ、読話されていることを充分に理解してゆっくりと明瞭に話している発話者の正面で、しかも至近距離から読み取ったとしても、100%の内容を読み取れるものではなく、発話の内容を同定できる確率は30%から40%前後といいます。なので、カメラを使って唇の動きを読むだけで音声認識するのは技術的にハードルが高いもののようです。

ではまた。