2023年5月17日、Appleが認知、視覚、聴覚、身体機能のアクセシビリティのためのソフトウェア機能、および非発話者や発話能力を失うリスクのある人のためのイノベーティブなツールを発表しました。

今回発表された機能は多岐に渡りますが、Audiostart Newsとしては音声領域の2つの新機能「Live Speech」「Personal Voice」にフォーカスして紹介していきます。

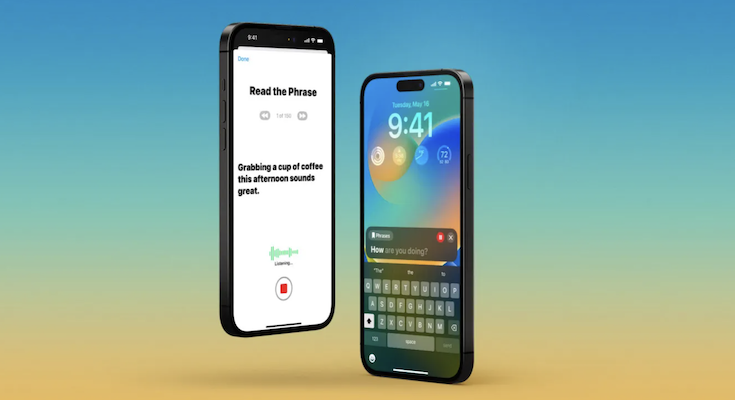

Apple / Appleは、認知のアクセシビリティのための新機能のほか、Live Speech、Personal Voice、拡大鏡のPoint and Speakを導入します

「Live Speech」(ライブスピーチ)とは?

「Live Speech」は、発話できないまたは徐々に発話能力を失っている、世界中の何百万人もの非発話者の方々をサポートするために設計された機能です。

iPhone、iPad、Macで「Live Speech」を使うことで、電話、FaceTime通話、対面などの会話中に自分が話したいことをタイプして話せるようになります。よく使うフレーズを保存しておくことで、タップするだけで発話することも出来るとのこと。手持ちのデバイスでText to Speach(TTS)が簡単に使えるようになるのは素晴らしいことですね。

「Personal Voice」(パーソナルボイス)とは?

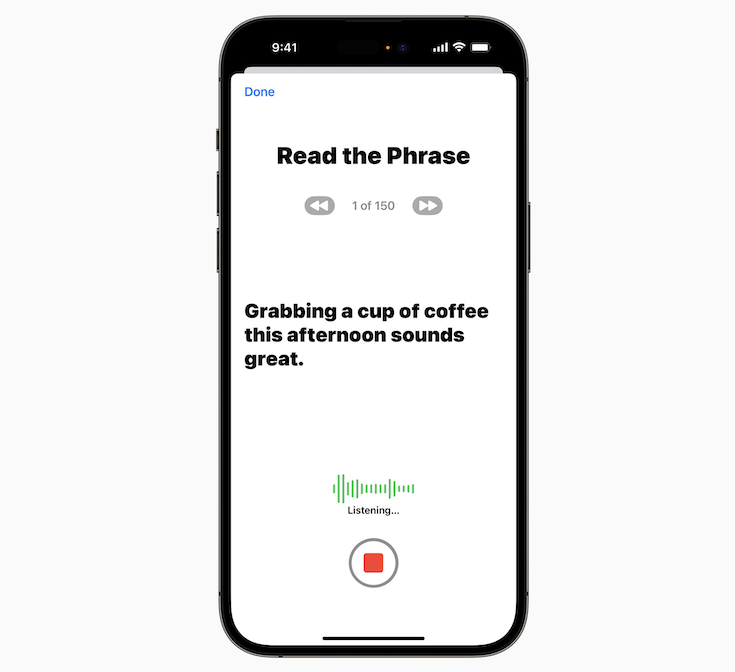

続いて「Personal Voice」ですが、これはALS患者や徐々に発話能力に影響が及ぶ可能性のあるその他の病気の診断を受けてまもない人など、発話能力を失うリスクのある人が、自分が話しているように聞こえる合成音声を作る機能です。

ユーザーは、iPhoneまたはiPadでランダムに選ばれたテキストプロンプトのセットを読んで音声をわずか15分間録音することで、Personal Voiceを作成できるようになります。またAppleらしく、デバイス上の機械学習を使ってユーザー情報のプライバシーとセキュリティを守り、前述のLive Speechとシームレスに統合して、ユーザーが大切な人とつながる時にPersonal Voiceで話すことができるとのこと。

これらのアクセシビリティ新機能は、今年後半のOSアップデートで利用できるようになります。リリースされ次第、改めて紹介したいと思います。

ではまた!